课程介绍

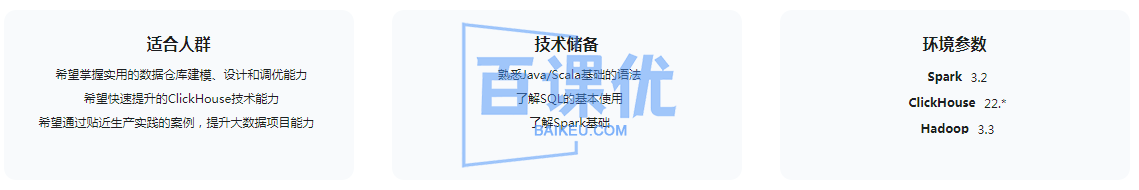

本课程来自某课网,经百课优(baikeu.com)精心整理发布,是一套Spark+ClickHouse实战企业级数据仓库课程。现阶段数仓技术已成了大厂面试必考的一环。本课程将结合ClickHouse+Spark ,以大数据量企业数据仓库为例,实战大数据数据仓库的建模、设计与调优等实用技巧,系统掌握ClickHouse核心技能与生产实践,全方位提升项目开发经验,进军大厂!

课程目录

├── 1-从0到1搭建项目开发环境,快速上手大数据开发/

│ ├── [ 20M] 1-1 大数据时代,你还不知道数据仓库么?

│ ├── [2.6M] 1-2 本章概览

│ ├── [ 36M] 1-3 基于IDEA + Maven构建Spark工程

│ ├── [ 50M] 1-4 源码、启动脚本、配置等自动构建打包

│ └── [ 58M] 1-5 项目多模块规划与自动构建打包

├── 2-项目关键技术准备,学习通用的数据处理技术/

│ ├── [4.8M] 2-1 本章概览

│ ├── [ 25M] 2-2 IPv4和数值转换

│ ├── [ 10M] 2-3 IP地址简写和全写的格式转换

│ ├── [ 34M] 2-4 IP地址二分查找

│ ├── [ 10M] 2-5 Spark自定义IP函数

│ ├── [ 51M] 2-6 初识Grok通用数据解析器

│ ├── [ 23M] 2-7 在程序中解析Grok

│ ├── [ 25M] 2-8 自定义Grok表达式

│ ├── [ 22M] 2-9 Grok工具类封装

│ ├── [ 35M] 2-10 在Spark中集成Grok

│ └── [ 22M] 2-11 Grok的序列化问题与源码修改

├── 3-项目数据准备,操练基于Spark的数据开发与优化/

│ ├── [2.0M] 3-1 本章概览

│ ├── [ 15M] 3-2 项目业务数据

│ ├── [ 29M] 3-3 生成IP、域名、IP位置的中间数据(上)

│ ├── [ 46M] 3-4 生成IP、域名、IP位置的中间数据(下)

│ ├── [ 30M] 3-5 生成域名备案、IP位置、违规实体数据

│ ├── [ 70M] 3-6 基于Grok模拟安全访问日志

│ └── [ 11M] 3-7 安全访问日志生成之广播变量优化

├── 4-初识OLAP数仓架构/

│ ├── [1.3M] 4-1 本章概览

│ ├── [ 12M] 4-2 基于Lambda架构的数仓

│ ├── [5.8M] 4-3 基于Kappa架构的数仓

│ └── [ 10M] 4-4 基于实时OLAP架构的数仓

├── 5-详解数据仓库基础理论,掌握数据仓库的实施流程/

│ ├── [3.3M] 5-1 本章概览

│ ├── [9.1M] 5-2 数据仓库的定义

│ ├── [ 10M] 5-3 3NF范式建模

│ ├── [9.8M] 5-4 Kimball和Inmon数据仓库架构

│ ├── [ 15M] 5-5 数据仓库建模方法

│ ├── [ 13M] 5-6 事实表与维度表

│ ├── [8.0M] 5-7 星型、雪花和星座维度模型

│ ├── [ 12M] 5-8 数据仓库构建流程

│ └── [ 21M] 5-9 数据仓库分层模型

├── 6-【项目实战第一篇】项目业务流程与ODS层数据同步/

│ ├── [1.8M] 6-1 课程目录

│ ├── [7.9M] 6-2 项目业务流程与技术架构

│ ├── [8.8M] 6-3 ODS数据同步技术架构

│ ├── [ 62M] 6-4 基于HDFS API的数据同步

│ ├── [ 78M] 6-5 基于HDFS API的数据同步工具封装

│ └── [ 41M] 6-6 业务数据库的数据同步

├── 7-快速上手OLAP分析引擎ClickHouse/

│ ├── [2.6M] 7-1 本章概览

│ ├── [ 29M] 7-2 初识OLAP分析引擎ClickHouse

│ ├── [ 14M] 7-3 ClickHouse与MySQL、Hbase、Elasticsearch

│ ├── [ 10M] 7-4 ClickHouse单机版安装

│ ├── [ 26M] 7-5 ClickHouse快速入门

│ ├── [ 36M] 7-6 ClickHouse-client使用

│ ├── [ 15M] 7-7 可视化工具DBeaver安装配置

│ ├── [ 13M] 7-8 ClickHouse表引擎快速入门

│ └── [ 24M] 7-9 ClickHouse学习建议

├── 8-基于Spark源码自定义ClickHouse外部数据源,简化数据写入流程/

│ ├── [2.7M] 8-1 本章概览

│ ├── [ 62M] 8-2 JDBC操作ClickHouse

│ ├── [ 63M] 8-3 使用Spark将数据写入ClickHouse

│ ├── [ 51M] 8-4 Spark写ClickHouse的配置化改造

│ ├── [ 84M] 8-5 在Spark中集成写ClickHouse的通用能力

│ └── [ 85M] 8-6 基于Spark源码自定义ClickHouse外部数据源

├── 9-数仓高级之维度模型设计/

│ ├── [3.0M] 9-1 本章概览

│ ├── [ 13M] 9-2 维度相关基本概念

│ ├── [4.1M] 9-3 维度设计的基本方法

│ ├── [5.5M] 9-4 维度设计的反规范化

│ ├── [8.8M] 9-5 一致性维度集成

│ ├── [ 17M] 9-6 维度模型设计原则和方式

│ ├── [ 30M] 9-7 缓慢变化维度SCD

│ ├── [ 14M] 9-8 维度的层次关系

│ └── [ 14M] 9-9 其他常见的维度模型

├── 10-【项目实战第二篇】构建项目公共维度层/

│ ├── [2.7M] 10-1 本章概览

│ ├── [ 55M] 10-2 反规范化维度合并之应用内容的模型设计与实现

│ ├── [ 22M] 10-3 公共方法封装

│ ├── [3.6M] 10-4 维度合并拆分之IP域名备案模型设计

│ ├── [ 29M] 10-5 IP域名备案维度代码实现

│ ├── [ 33M] 10-6 违规IP域名数据入库

│ ├── [5.4M] 10-7 维度层次结构扁平化之IP地址段区域维度模型设计

│ └── [ 38M] 10-8 IP地址段区域维度代码实现

├── 11-ClickHouse的MergeTree系列引擎原理、实践与优化/

│ ├── [3.7M] 11-1 本章概览

│ ├── [7.3M] 11-2 表引擎概述

│ ├── [ 34M] 11-3 MergeTree引擎

│ ├── [ 31M] 11-4 数据片段存储合并机制与自定义分区

│ ├── [ 17M] 11-5 主键、索引、数据标记的工作机制

│ ├── [ 61M] 11-6 性能优化利器之跳数索引的基本使用

│ ├── [ 27M] 11-7 性能优化利器之跳数索引实现原理与使用场景

│ ├── [ 45M] 11-8 性能优化利器之Projection

│ ├── [ 21M] 11-9 ReplacingMergeTree引擎

│ ├── [ 12M] 11-10 SummingMergeTree引擎

│ ├── [ 26M] 11-11 AggregatingMergeTree引擎

│ ├── [ 20M] 11-12 CollapsingMergeTree引擎

│ ├── [9.9M] 11-13 VersionedCollapsingMergeTree引擎

│ ├── [ 26M] 11-14 MergeTree系列引擎选型对比

│ └── [ 31M] 11-15 数据实时更新删除

├── 12-数仓高级之事实表模型设计/

│ ├── [2.2M] 12-1 本章概览

│ ├── [ 18M] 12-2 事实表设计过程

│ ├── [ 16M] 12-3 事务、无事实事实表模型设计

│ ├── [ 15M] 12-4 多事务事实表模型设计

│ ├── [7.7M] 12-5 周期快照事实表模型设计

│ ├── [ 17M] 12-6 累积快照事实表模型设计

│ ├── [6.6M] 12-7 聚集事实表模型设计

│ └── [8.0M] 12-8 六类事实表对比

├── 13-【项目实战第三篇】数据清洗加工,构建项目数据明细层/

│ ├── [2.7M] 13-1 本章概览

│ ├── [7.4M] 13-2 事务无事实事实表模型建模

│ ├── [ 64M] 13-3 日志事务事实表代码实现(上)

│ ├── [ 53M] 13-4 日志事务事实表代码实现(下)

│ ├── [ 31M] 13-5 日志拦截无事实事实表代码实现

│ ├── [ 21M] 13-6 累计快照事实表建模与代码实现

│ ├── [ 52M] 13-7 Spark资源参数调优

│ ├── [ 43M] 13-8 大数据量场景下的程序部署与优化实践

│ └── [ 25M] 13-9 周期性快照事实表模型设计与实现

├── 14-构建ClickHouse分布式集群,掌握分布式环境的数据查询、写入优化方案/

│ ├── [1.5M] 14-1 本章概览

│ ├── [ 32M] 14-2 集群规划与环境准备

│ ├── [ 46M] 14-3 ClickHouse集群安装配置

│ ├── [ 30M] 14-4 ClickHouse集群功能验证

│ ├── [ 10M] 14-5 ClickHouse的原子写入与去重

│ ├── [ 22M] 14-6 复制表与副本同步机制

│ └── [ 14M] 14-7 分布式表与本地表

├── 15-【项目实战第四篇】负载均衡与高可用方案实践,自定义Spark写本地分片表策略/

│ ├── [2.8M] 15-1 本章概览

│ ├── [6.5M] 15-2 负载均衡与高可用五问

│ ├── [7.5M] 15-3 分布式请求的副本高可用和负载均衡

│ ├── [7.6M] 15-4 基于代码层面的负载均衡与高可用

│ ├── [ 61M] 15-5 基于Nginx反向代理TCP与HTTP的负载均衡与高可用

│ ├── [ 42M] 15-6 基于Chproxy的负载均衡与高可用

│ ├── [9.5M] 15-7 Spark如何写本地表方案

│ ├── [ 62M] 15-8 Spark写本地表之随机策略代码实现

│ ├── [ 18M] 15-9 Spark写本地表之轮询策略代码实现

│ ├── [ 32M] 15-10 大数据量场景写ClickHouse集群的程序部署与优化

│ └── [5.9M] 15-11 Spark自定义分片路由与方案总结

├── 16-【项目实战第五篇】如何选择合适的维度表存储方案/

│ ├── [2.8M] 16-1 本章概览

│ ├── [ 13M] 16-2 Log系列引擎

│ ├── [ 22M] 16-3 MySQL引擎

│ ├── [ 22M] 16-4 HDFS引擎与HA配置

│ ├── [ 23M] 16-5 高性能数据检索的RocksDB引擎

│ ├── [ 11M] 16-6 Merge表引擎

│ ├── [ 18M] 16-7 Join表引擎

│ ├── [ 49M] 16-8 深入浅出ClickHouse数据字典(上)

│ ├── [ 43M] 16-9 深入浅出ClickHouse数据字典(下)

│ ├── [ 10M] 16-10 分布式场景的表关联子查询的运行流程与优化

│ ├── [ 12M] 16-11 分布式场景下的维度表存储选型优化

│ └── [ 32M] 16-12 项目的维度表存储优化

├── 17-【项目实战第六篇】数据汇总层与应用查询优化/

│ ├── [2.3M] 17-1 本章概览

│ ├── [ 11M] 17-2 主键与排序键优化

│ ├── [ 13M] 17-3 聚合查询优化

│ ├── [ 10M] 17-4 物化视图提速

│ ├── [ 42M] 17-5 DWS层之IP流量监测主题

│ ├── [ 26M] 17-6 DWS层之区域流量分析主题

│ ├── [ 39M] 17-7 构建数据应用层(ADS)

│ ├── [ 18M] 17-8 应用查询优化案例

│ └── [4.3M] 17-9 数据写入与查询优化常用经验法则

├── 18-【项目实战第七篇】基于轻量级BI工具的数据展示与可视化监控/

│ ├── [2.8M] 18-1 本章概览

│ ├── [5.7M] 18-2 基于轻量级BI工具的数据可视化效果

│ ├── [ 52M] 18-3 Superset环境搭建与基本使用

│ ├── [ 28M] 18-4 Superset查询分析可视化展示

│ ├── [ 25M] 18-5 Grafana的安装与ClickHouse数据源管理

│ ├── [ 22M] 18-6 Granfana查询分析可视化展示

│ ├── [5.8M] 18-7 ClickHouse监控概述

│ ├── [9.1M] 18-8 ClickHouse系统表+ Granfana可视化监控

│ ├── [ 15M] 18-9 Promethues安装与ClickHouse的metric采集

│ └── [ 14M] 18-10 prometheus + Granfana可视化监控

├── 19-数仓管理之调度系统DolphinScheduler 3.x/

│ ├── [5.1M] 19-1 本章概览

│ ├── [ 15M] 19-2 我们为什么需要配合调度系统

│ ├── [ 16M] 19-3 DolphinScheduler单机部署

│ ├── [ 33M] 19-4 快速上手DolphinScheduler

│ ├── [ 11M] 19-5 DolphinScheduler源码编译

│ ├── [ 55M] 19-6 DolphinScheduler伪集群安装

│ ├── [ 12M] 19-7 工作流管理之子流程管理

│ ├── [ 19M] 19-8 工作流管理之依赖检查管理

│ ├── [ 14M] 19-9 工作流管理之Conditions条件分支判断

│ ├── [ 12M] 19-10 工作流管理之Switch条件分支判断

│ ├── [ 55M] 19-11 本地和HDFS两种文件资源管理方式

│ ├── [ 45M] 19-12 内置参数、本地参数、全局参数和参数传递

│ ├── [ 24M] 19-13 如何动态生成自定义参数

│ ├── [ 30M] 19-14 Spark任务节点管理

│ ├── [ 19M] 19-15 流程告警管理

│ ├── [ 82M] 19-16 数仓项目之文件数据源同步

│ └── [ 27M] 19-17 数仓项目之Spark工作流调度

├── 20-构建现代数据技术栈的元数据管理平台/

│ ├── [5.7M] 20-1 本章概览

│ ├── [ 19M] 20-2 为什么数仓管理中需要元数据管理

│ ├── [ 20M] 20-3 元数据体系架构的演进

│ ├── [ 17M] 20-4 DataHub的元数据体系架构

│ ├── [ 46M] 20-5 DataHub元数据系统搭建

│ ├── [8.4M] 20-6 基于Pull(拉取)流程的元数据摄取

│ ├── [ 27M] 20-7 基于Pull的元数据摄取实践

│ ├── [ 28M] 20-8 DataHub的MetaData元数据模型

│ ├── [ 22M] 20-9 基于Kafka的Sink接收器同步MySQL元数据

│ ├── [ 19M] 20-10 ClickHouse的元数据摄取实践

│ ├── [9.2M] 20-11 可视化BI工具的元数据摄取

│ ├── [ 13M] 20-12 构建数据集之间的血缘链路实践

│ └── [ 14M] 20-13 构建数据集与可视化BI工具的血缘链路实践

├── 21-通用数据质量管理实践/

│ ├── [4.8M] 21-1 本章概览

│ ├── [ 12M] 21-2 如果数仓不考虑数据质量会有什么危害

│ ├── [ 10M] 21-3 数据质量评估标准

│ ├── [ 19M] 21-4 数据质量管理架构与数据模型

│ ├── [ 41M] 21-5 通用数据质量管理工具之配置逻辑

│ ├── [ 70M] 21-6 通用数据质量管理工具之代码实践

│ ├── [ 21M] 21-7 通用数据质量管理工具之历史周期性质量指标对比

│ ├── [ 19M] 21-8 单数据源的检查之唯一性校验

│ ├── [ 14M] 21-9 单数据源的检查之表字段长度校验

│ ├── [ 11M] 21-10 单数据源的检查之表记录数检查

│ ├── [ 11M] 21-11 单数据源的检查之枚举值校验

│ └── [ 15M] 21-12 多数据源检查之准确性检查

└── 资料代码/

学员评价

慕勒9579271 好评

课程的Grok看起来还不错, 我们有大量非结构化的日志需要解析,以前在Logstash中配置Grok解析,但是Logstash性能没办法扩展,用起来还是比较复杂。准备使用Spark做一个自己的Grok数据解析工具,数据源是文件,解析后存到Elasticsearch,老师能提供下实现思路吗?

1、本站信息来自网络,版权争议与本站无关

2、本站所有主题由该帖子作者发表,该帖子作者与本站享有帖子相关版权

3、其他单位或个人使用、转载或引用本文时必须同时征得该帖子作者和本站的同意

4、本帖部分内容转载自其它媒体,但并不代表本站赞同其观点和对其真实性负责

5、用户所发布的一切软件的解密分析文章仅限用于学习和研究目的;不得将上述内容用于商业或者非法用途,否则,一切后果请用户自负。

6、您必须在下载后的24个小时之内,从您的电脑中彻底删除上述内容。

7、请支持正版软件、得到更好的正版服务。